在分布式系统中,消息队列(MQ)是实现异步处理、系统解耦和提高吞吐量的重要组件。然而,消息丢失是使用消息队列时可能遇到的一个关键问题。本文将通过对比 RabbitMQ、RocketMQ 和 Apache Kafka,探讨消息丢失的原因,并介绍如何通过各种机制和策略来解决和补救消息丢失问题。

一、消息丢失的原因消息丢失可能发生在消息的生产、传输和消费的各个环节。以下是一些常见原因:

生产者故障:在生产者发送消息到消息队列之前,若生产者发生故障,消息可能未能成功发送。网络问题:网络不稳定或网络分区可能导致消息在传输过程中丢失。消息队列故障:消息队列服务本身的故障(如崩溃或数据丢失)可能导致消息丢失。消费者故障:消费者在处理消息时发生故障,可能导致消息未能被正确处理和确认。消息过期:消息在消息队列中存储超过一定时间(TTL)后,可能被自动删除。配置错误:不正确的消息队列配置或使用不当的确认机制,可能导致消息丢失。二、如何解决消息队列丢失为了防止消息丢失,可以采取以下措施和策略:

案例实现:银行交易系统

消息确认机制:使用消息确认机制(acknowledgments),确保消息被消费者正确处理后才从队列中移除。 Channel channel = connection.createChannel(); channel.basicConsume(queueName, false, new DefaultConsumer(channel) { @Override public void handleDelivery(String consumerTag, Envelope envelope, AMQP.BasicProperties properties, byte[] body) throws IOException { String message = new String(body, "UTF-8"); try { // 处理消息 processMessage(message); channel.basicAck(envelope.getDeliveryTag(), false); } catch (Exception e) { channel.basicNack(envelope.getDeliveryTag(), false, true); } } });持久化消息:将消息标记为持久化,确保 RabbitMQ 重启后消息不会丢失。

channel.queueDeclare(queueName, true, false, false, null); channel.basicPublish("", queueName, MessageProperties.PERSISTENT_TEXT_PLAIN, message.getBytes());镜像队列:在集群环境中使用镜像队列(Mirrored Queues),确保消息在多个节点上复制,提高可靠性。

rabbitmqctl set_policy ha-all "" '{"ha-mode":"all"}'2. RocketMQ

案例实现:电商订单系统

消息重试机制:RocketMQ 生产者和消费者都支持重试机制,在发送或消费失败时进行重试。 DefaultMQProducer producer = new DefaultMQProducer("ProducerGroupName"); producer.setRetryTimesWhenSendFailed(3);消息持久化:RocketMQ 自动将消息持久化到磁盘,并且可以配置不同的持久化策略(如同步刷盘和异步刷盘)。

brokerConfig.setFlushDiskType(FlushDiskType.SYNC_FLUSH);主备机制:RocketMQ 支持多副本机制,通过主备同步确保消息在多个节点上有备份。

brokerRole = ASYNC_MASTER3. Apache Kafka

案例实现:网站点击流数据分析

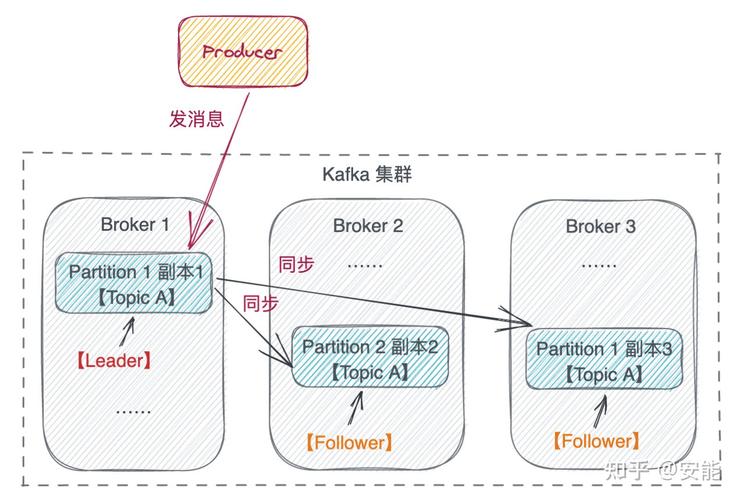

生产者确认机制:配置生产者等待所有副本确认(acks=all),确保消息被所有副本接收。 Properties props = new Properties(); props.put("acks", "all"); KafkaProducer<String, String> producer = new KafkaProducer<>(props);持久化消息:Kafka 默认将消息持久化到磁盘,并通过分区和副本机制提供高可用性。

log.dirs=/var/lib/kafka/logs default.replication.factor=3消费者偏移量管理:通过手动提交偏移量,确保消费者在成功处理消息后再标记为已消费。

consumer.commitSync();三、出现消息丢失后的补救措施

即便采取了上述措施,仍可能出现消息丢失的情况。以下是几种补救策略:

1. RabbitMQ案例实现:银行交易系统

死信队列处理:配置死信队列(Dead Letter Exchange),将处理失败的消息转移到死信队列,以便后续分析和处理。 Map<String, Object> args = new HashMap<>(); args.put("x-dead-letter-exchange", "dlx-exchange"); channel.queueDeclare(queueName, true, false, false, args);重处理死信消息:开发专门的工具或脚本,将死信队列中的消息重新投递或进行人工干预处理。2. RocketMQ

案例实现:电商订单系统

重放机制:RocketMQ 支持根据消息存储时间范围重放消息。通过调整消费进度,重新消费一段时间内的消息。 consumer.seek(new MessageQueue(topic, brokerName, queueId), timestamp);死信队列处理:RocketMQ 也支持死信队列,可以将消费失败的消息发送到死信队列。3. Apache Kafka

案例实现:网站点击流数据分析

数据校验机制:在消息生产和消费的各个环节进行数据校验,确保消息的完整性和一致性。消息重放机制:通过重新设置消费者偏移量,实现消息重放,重新消费丢失的消息。 consumer.seek(new TopicPartition(topic, partition), offset);四、总结

通过具体的 RabbitMQ、RocketMQ 和 Apache Kafka 实现案例,我们可以看到如何在生产者、消息队列服务本身以及消费者端采取措施,防止消息丢失。此外,日志和监控、死信队列处理以及数据校验和重放等补救措施也为我们提供了应对消息丢失的有效方法。在实际应用中,结合这些策略,可以构建一个健壮的消息队列系统,确保消息在生产、传输和消费各个环节的可靠性。选择合适的消息队列取决于具体的应用场景和需求,理解它们各自的优缺点将帮助我们做出更明智的选择。